Quelle:

Microsoft Trustworthy AI: Unlocking human potential starts with trust – The Official Microsoft Blog

Deutscher Blogbeitrag: Microsoft Trustworthy AI: Menschliches Potenzial zu entfalten beginnt mit Vertrauen | News Center Microsoft

Übersetzung mit DeepL

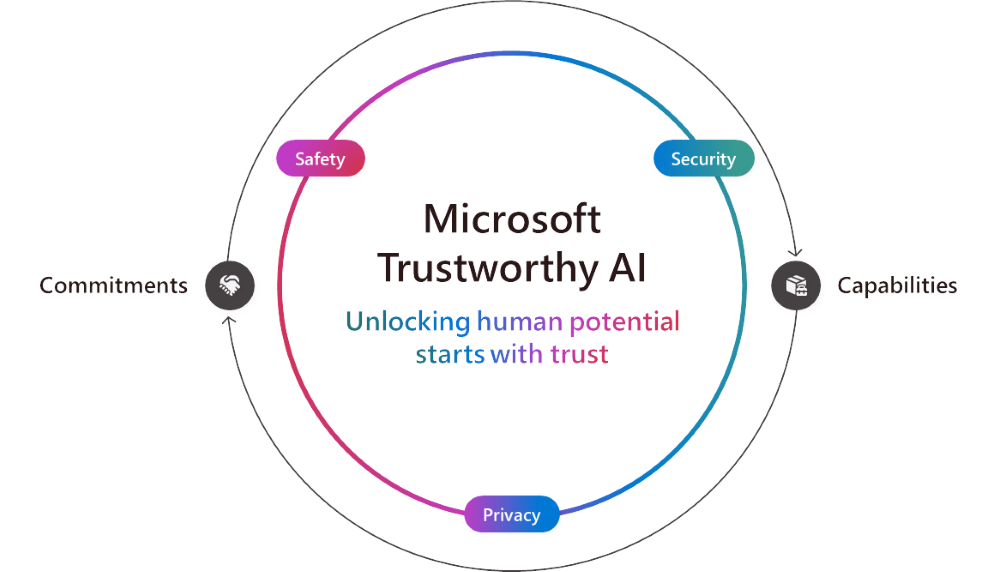

Mit dem Fortschritt der KI kommt uns allen eine Rolle zu, um die positiven Auswirkungen der KI für Organisationen und Gemeinschaften auf der ganzen Welt zu erschließen. Deshalb konzentrieren wir uns darauf, Kunden bei der Nutzung und Entwicklung von KI zu unterstützen, die vertrauenswürdig ist, d. h. KI, die sicher, geschützt und privat ist.

Bei Microsoft haben wir uns verpflichtet, vertrauenswürdige KI zu gewährleisten, und entwickeln branchenführende unterstützende Technologien. Unsere Verpflichtungen und Fähigkeiten gehen Hand in Hand, um sicherzustellen, dass unsere Kunden und Entwickler auf jeder Ebene geschützt sind.

Aufbauend auf unseren Verpflichtungen kündigen wir heute neue Funktionen für Produkte an, um die Sicherheit und den Datenschutz von KI-Systemen zu stärken.

Sicherheit. Sicherheit hat bei Microsoft oberste Priorität, und unsere erweiterte Secure Future Initiative (SFI) unterstreicht das unternehmensweite Engagement und die Verantwortung, die wir für die Sicherheit unserer Kunden empfinden. Diese Woche haben wir unseren ersten SFI-Fortschrittsbericht vorgestellt, in dem Aktualisierungen in den Bereichen Kultur, Governance, Technologie und Betrieb hervorgehoben werden. Damit lösen wir unser Versprechen ein, der Sicherheit Vorrang vor allem anderen einzuräumen, und orientieren uns dabei an drei Grundsätzen: „Secure by Design“, „Secure by Default“ und „Secure Operations“. Zusätzlich zu unseren Erstanbieter-Angeboten, Microsoft Defender und Purview, sind unsere KI-Dienste mit grundlegenden Sicherheitskontrollen ausgestattet, wie z. B. integrierten Funktionen zur Verhinderung von Prompt Injections und Urheberrechtsverletzungen. Darauf aufbauend kündigen wir heute zwei neue Funktionen an:

- Evaluierungen in Azure AI Studio zur Unterstützung proaktiver Risikobewertungen.

- Microsoft 365 Copilot wird Transparenz in Webabfragen bieten, um Administratoren und Benutzern ein besseres Verständnis dafür zu vermitteln, wie die Websuche die Copilot-Antwort verbessert. Bald verfügbar.

Unsere Sicherheitsfunktionen werden bereits von Kunden genutzt. Cummins, ein 105 Jahre altes Unternehmen, das für die Herstellung von Motoren und die Entwicklung sauberer Energietechnologien bekannt ist, setzte auf Microsoft Purview, um die Datensicherheit und -verwaltung durch die Automatisierung der Klassifizierung, Kennzeichnung und Beschriftung von Daten zu verbessern. EPAM Systems, ein Softwareentwicklungs- und Unternehmensberatungsunternehmen, hat Microsoft 365 Copilot für 300 Benutzer bereitgestellt, da es von Microsoft Datenschutz erhält. J.T. Sodano, Senior Director of IT, teilte mit, dass „wir mit Copilot für Microsoft 365 im Vergleich zu anderen großen Sprachmodellen (LLMs) viel mehr Vertrauen hatten, weil wir wissen, dass die gleichen Informations- und Datenschutzrichtlinien, die wir in Microsoft Purview konfiguriert haben, auch für Copilot gelten.“

Sicherheit. Die umfassenderen Grundsätze für verantwortungsvolle KI von Microsoft, die 2018 eingeführt wurden und sowohl Sicherheit als auch Datenschutz umfassen, sind weiterhin maßgeblich für die sichere Entwicklung und Bereitstellung von KI im gesamten Unternehmen. In der Praxis bedeutet dies, dass Systeme ordnungsgemäß erstellt, getestet und überwacht werden müssen, um unerwünschte Verhaltensweisen wie schädliche Inhalte, Voreingenommenheit, Missbrauch und andere unbeabsichtigte Risiken zu vermeiden. Im Laufe der Jahre haben wir erhebliche Investitionen in den Aufbau der erforderlichen Governance-Strukturen, Richtlinien, Tools und Prozesse getätigt, um diese Grundsätze einzuhalten und KI sicher zu entwickeln und einzusetzen. Bei Microsoft sind wir bestrebt, unsere Erkenntnisse auf diesem Weg zur Einhaltung unserer Grundsätze für verantwortungsvolle KI mit unseren Kunden zu teilen. Wir nutzen unsere eigenen bewährten Verfahren und Erkenntnisse, um Menschen und Organisationen mit Fähigkeiten und Tools auszustatten, mit denen sie KI-Anwendungen erstellen können, die dieselben hohen Standards erfüllen, die wir anstreben.

Heute stellen wir neue Funktionen vor, mit denen Kunden die Vorteile der KI nutzen und gleichzeitig die Risiken minimieren können:

- Eine Korrekturfunktion in Microsoft Azure KI Content Safety’s Groundedness-Erkennungsfunktion, die dabei hilft, Halluzinationsprobleme in Echtzeit zu beheben, bevor sie von den Benutzern bemerkt werden.

- Embedded Content Safety, mit dem Kunden Azure KI Content Safety auf Geräten einbetten können. Dies ist wichtig für Szenarien auf dem Gerät, bei denen die Cloud-Verbindung unterbrochen oder nicht verfügbar sein könnte.

- Neue Auswertungen in Azure AI Studio helfen Kunden, die Qualität und Relevanz von Ergebnissen zu bewerten und zu ermitteln, wie oft ihre KI-Anwendung geschütztes Material ausgibt.

- Die Erkennung geschützter Materialien für Code ist jetzt in Azure AI Content Safety als Vorschau verfügbar, um bereits vorhandene Inhalte und Codes zu erkennen. Diese Funktion hilft Entwicklern, öffentlichen Quellcode in GitHub-Repositorys zu untersuchen, fördert die Zusammenarbeit und Transparenz und ermöglicht fundiertere Entscheidungen bei der Programmierung.

Es ist erstaunlich zu sehen, wie Kunden aus verschiedenen Branchen bereits Microsoft-Lösungen nutzen, um sicherere und vertrauenswürdigere KI-Anwendungen zu erstellen. So hat beispielsweise Unity, eine Plattform für 3D-Spiele, den Microsoft Azure OpenAI Service genutzt, um Muse Chat zu entwickeln, einen KI-Assistenten, der die Spieleentwicklung erleichtert. Muse Chat verwendet Inhaltsfilterungsmodelle in Azure AI Content Safety, um eine verantwortungsvolle Nutzung der Software zu gewährleisten. Darüber hinaus nutzte ASOS, ein britischer Modehändler mit fast 900 Markenpartnern, dieselben integrierten Inhaltsfilter in Azure AI Content Safety, um über eine KI-App, die Kunden bei der Suche nach neuen Looks unterstützt, Interaktionen in höchster Qualität zu ermöglichen.

Auch im Bildungsbereich sehen wir die Auswirkungen. New York City Public Schools haben in Zusammenarbeit mit Microsoft ein sicheres und für den Bildungskontext geeignetes Chat-System entwickelt, das sie nun in Schulen testen. Das Bildungsministerium von Südaustralien hat mit EdChat ebenfalls generative KI in den Unterricht gebracht und sich dabei auf dieselbe Infrastruktur verlassen, um eine sichere Nutzung für Schüler und Lehrer zu gewährleisten.

Datenschutz. Daten bilden die Grundlage der KI, und Microsoft hat es sich zur Aufgabe gemacht, durch unsere langjährigen Datenschutzgrundsätze, zu denen Benutzerkontrolle, Transparenz sowie rechtliche und regulatorische Schutzmaßnahmen gehören, sicherzustellen, dass Kundendaten geschützt und konform sind. Darauf aufbauend kündigen wir heute Folgendes an:

- Vertrauliche Inferenzierung in der Vorschau in unserem Azure OpenAI Service Whisper-Modell, damit Kunden generative KI-Anwendungen entwickeln können, die einen überprüfbaren End-to-End-Datenschutz unterstützen. Vertrauliche Inferenzierung stellt sicher, dass sensible Kundendaten während des Inferenzierungsprozesses sicher und privat bleiben, d. h. wenn ein trainiertes KI-Modell auf der Grundlage neuer Daten Vorhersagen oder Entscheidungen trifft. Dies ist besonders wichtig für stark regulierte Branchen wie das Gesundheitswesen, Finanzdienstleistungen, Einzelhandel, Fertigung und Energie.

- Die allgemeine Verfügbarkeit von Azure Confidential VMs mit NVIDIA H100 Tensor Core GPUs, die es Kunden ermöglichen, Daten direkt auf dem Grafikprozessor zu sichern. Dies baut auf unseren vertraulichen Computerlösungen auf, die sicherstellen, dass Kundendaten verschlüsselt und in einer sicheren Umgebung geschützt bleiben, sodass niemand ohne Erlaubnis auf die Informationen oder das System zugreifen kann.

- Azure OpenAI Data Zones für die EU und die USA sind in Kürze verfügbar und bauen auf der bestehenden Datenresidenz des Azure OpenAI Service auf, indem sie die Verwaltung der Datenverarbeitung und -speicherung generativer KI-Anwendungen vereinfachen. Diese neue Funktionalität bietet Kunden die Flexibilität, generative KI-Anwendungen über alle Azure-Regionen innerhalb einer Region hinweg zu skalieren, während sie gleichzeitig die Kontrolle über die Datenverarbeitung und -speicherung innerhalb der EU oder der USA behalten.

Wir haben ein zunehmendes Interesse der Kunden an Confidential Computing und Begeisterung für Confidential GPUs festgestellt, unter anderem beim Anbieter für Anwendungssicherheit F5, der Azure Confidential VMs mit NVIDIA H100 Tensor Core GPUs verwendet, um fortschrittliche KI-gestützte Sicherheitslösungen zu entwickeln und gleichzeitig die Vertraulichkeit der von seinen Modellen analysierten Daten zu gewährleisten. Und das multinationale Bankunternehmen Royal Bank of Canada (RBC) hat Azure Confidential Computing in seine eigene Plattform integriert, um verschlüsselte Daten zu analysieren und gleichzeitig die Privatsphäre der Kunden zu wahren. Mit der allgemeinen Verfügbarkeit von Azure Confidential VMs mit NVIDIA H100 Tensor Core GPUs kann RBC diese fortschrittlichen KI-Tools nun nutzen, um effizienter zu arbeiten und leistungsfähigere KI-Modelle zu entwickeln.